2019年是人工智能技術(shù)從理論探索邁向大規(guī)模工業(yè)應(yīng)用的關(guān)鍵一年。在這一年里,基礎(chǔ)軟件作為AI技術(shù)落地的核心基石,經(jīng)歷了從框架深化、工具鏈完善到開源生態(tài)蓬勃發(fā)展的系統(tǒng)性突破。這一年,我們見證了易用性、高性能與產(chǎn)業(yè)融合成為主旋律,開發(fā)范式也悄然發(fā)生變革。

一、主流深度學(xué)習(xí)框架步入“戰(zhàn)國時代”,競爭與融合并存

以TensorFlow、PyTorch為代表的框架之爭在這一年愈演愈烈,但競爭焦點已從單純的模型訓(xùn)練效率,轉(zhuǎn)向了全棧支持能力和部署便捷性。

- TensorFlow 2.0的發(fā)布是年度最具影響力的事件之一。它通過全面擁抱Keras作為高階API,采用“Eager Execution”默認(rèn)為執(zhí)行模式,極大地降低了入門門檻和使用復(fù)雜性。其生態(tài)系統(tǒng)持續(xù)壯大,TensorFlow Lite在移動和邊緣端推理優(yōu)化上成果顯著,TensorFlow.js讓瀏覽器內(nèi)機(jī)器學(xué)習(xí)成為可能,而TensorFlow Extended (TFX) 則為生產(chǎn)級機(jī)器學(xué)習(xí)流水線提供了端到端解決方案。

- PyTorch鞏固學(xué)術(shù)與研究領(lǐng)域的王者地位,并強(qiáng)勢向工業(yè)界滲透。其1.3版本帶來了重要的量化支持、移動端部署(TorchScript)以及名為“Captum”的可解釋性工具庫,展示了從研究原型到生產(chǎn)部署的完整路徑。PyTorch Lightning等高級封裝庫的出現(xiàn),進(jìn)一步規(guī)范了研究代碼結(jié)構(gòu),提升了可復(fù)現(xiàn)性。

- 中國力量崛起,開源生態(tài)初具規(guī)模。百度的飛槳(PaddlePaddle) 在2019年實現(xiàn)了全面升級,在動態(tài)圖、分布式訓(xùn)練和產(chǎn)業(yè)預(yù)訓(xùn)練模型庫方面表現(xiàn)突出,尤其在中文NLP任務(wù)上提供了特色優(yōu)勢。華為開源的MindSpore首次亮相,主打“全場景”覆蓋(端、邊、云)和原生支持昇騰AI處理器,為國產(chǎn)AI基礎(chǔ)軟件注入新動力。

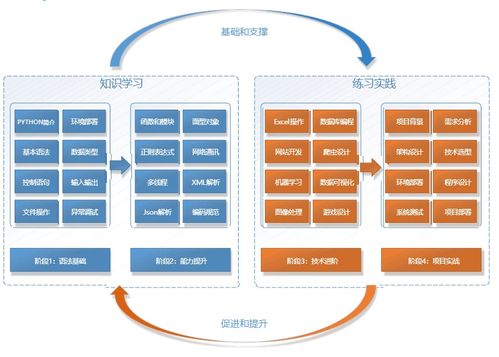

二、開發(fā)工具鏈與平臺:邁向自動化與標(biāo)準(zhǔn)化

AI開發(fā)正從“手工作坊”模式向“工業(yè)化流水線”演進(jìn),相關(guān)工具鏈的成熟是重要標(biāo)志。

- 自動化機(jī)器學(xué)習(xí)(AutoML)工具走向普及。Google Cloud AutoML、Azure Automated ML等云服務(wù)降低了模型構(gòu)建的門檻。開源的Auto-Keras、NNI(Neural Network Intelligence) 等項目讓研究人員和開發(fā)者能夠輕松進(jìn)行神經(jīng)架構(gòu)搜索(NAS)和超參數(shù)優(yōu)化,將專家經(jīng)驗沉淀為可復(fù)用的自動化流程。

- 模型部署與推理優(yōu)化成為核心關(guān)切。ONNX(Open Neural Network Exchange)格式作為中間表示,獲得了更多框架和硬件廠商的支持,促進(jìn)了模型在不同框架和硬件平臺間的流動。英偉達(dá)的TensorRT、英特爾的OpenVINO等推理優(yōu)化工具持續(xù)迭代,專注于在特定硬件上極致提升推理性能。模型壓縮、剪枝、量化等技術(shù)也從研究論文快速轉(zhuǎn)化為實用的工具庫。

- MLOps理念萌芽,平臺化工具涌現(xiàn)。隨著企業(yè)將大量AI模型投入生產(chǎn),模型的生命周期管理(開發(fā)、部署、監(jiān)控、迭代)變得至關(guān)重要。MLflow、Kubeflow等開源項目幫助團(tuán)隊構(gòu)建可重復(fù)、可協(xié)作、可管理的機(jī)器學(xué)習(xí)工作流,標(biāo)志著AI開發(fā)開始與DevOps理念深度融合。

三、開源模型庫與預(yù)訓(xùn)練模型:引爆應(yīng)用創(chuàng)新的“燃料”

2019年是預(yù)訓(xùn)練模型,尤其是大規(guī)模自然語言處理預(yù)訓(xùn)練模型的“爆發(fā)年”。這極大地改變了AI基礎(chǔ)軟件的開發(fā)方式——從零開始訓(xùn)練模型逐漸轉(zhuǎn)變?yōu)榛趶?qiáng)大預(yù)訓(xùn)練模型進(jìn)行微調(diào)(Fine-tuning)。

- NLP領(lǐng)域的“軍備競賽”:谷歌的BERT及其變種(如RoBERTa, ALBERT)統(tǒng)治了上半年;下半年,OpenAI的GPT-2(雖因倫理顧慮部分開源)展示了生成式模型的驚人潛力,而谷歌的T5模型則提出了“一切文本任務(wù)皆可轉(zhuǎn)化為文本到文本任務(wù)”的統(tǒng)一框架。這些模型通過Hugging Face的Transformers等開源庫被全球開發(fā)者便捷使用,極大地加速了NLP應(yīng)用的創(chuàng)新。

- 計算機(jī)視覺模型庫日益豐富:PyTorch的TorchVision、TensorFlow的TF-Hub等提供了豐富的預(yù)訓(xùn)練計算機(jī)視覺模型(如ResNet, EfficientNet等),覆蓋圖像分類、目標(biāo)檢測、分割等主流任務(wù),成為視覺應(yīng)用開發(fā)的標(biāo)配起點。

四、硬件專用軟件棧與異構(gòu)計算支持

AI算力需求激增,驅(qū)動專用AI芯片百花齊放,與之配套的軟件棧(編譯器、驅(qū)動、算子庫)成為基礎(chǔ)軟件不可或缺的部分。

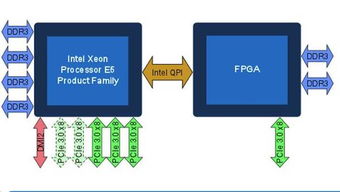

- CUDA生態(tài)依然堅固,但挑戰(zhàn)者出現(xiàn)。英偉達(dá)通過CUDA、cuDNN、NCCL等軟件棧構(gòu)建的護(hù)城河依然是主流選擇。針對特定場景(如終端、邊緣)和開源開放的軟件棧也在發(fā)展,例如基于LLVM/MLIR的編譯器基礎(chǔ)設(shè)施受到更多關(guān)注,旨在為不同硬件后端提供統(tǒng)一的編譯優(yōu)化支持。

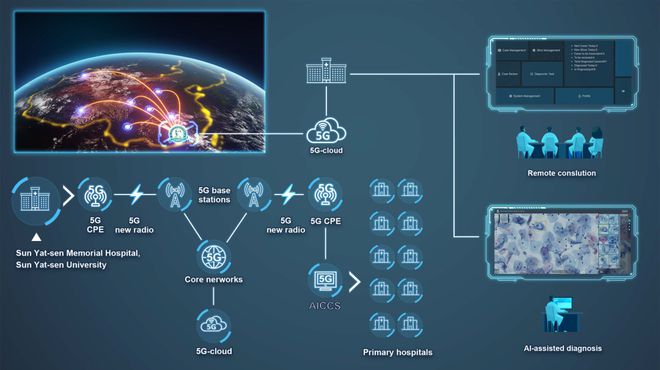

- 邊緣AI推理框架備受重視。隨著物聯(lián)網(wǎng)和5G發(fā)展,在資源受限設(shè)備上運行AI模型的需求迫切。除了TensorFlow Lite和PyTorch Mobile,小米的MACE、騰訊的NCNN等輕量級、高性能的移動端推理框架在2019年也日趨成熟,優(yōu)化了對ARM CPU、移動GPU及NPU的支持。

融合、降本與普惠

回顧2019年,人工智能基礎(chǔ)軟件的發(fā)展呈現(xiàn)出清晰的軌跡:框架追求易用與全棧,工具聚焦自動化與標(biāo)準(zhǔn)化,生態(tài)依賴開源與共享,部署瞄準(zhǔn)全場景與高性能。這些突破共同降低了AI技術(shù)的開發(fā)與應(yīng)用門檻,將開發(fā)者的注意力從重復(fù)的底層實現(xiàn)中解放出來,更多地聚焦于業(yè)務(wù)邏輯與創(chuàng)新本身。2019年的積淀,為接下來AI大規(guī)模產(chǎn)業(yè)化落地鋪平了軟件層面的道路,一個更加普惠、高效、規(guī)范的AI開發(fā)時代已然開啟。